Attention is All You Need

안녕하세요 여러분! 😊 오늘은 딥러닝과 자연어 처리의 혁신적인 전환점이 된 놀라운 논문인 "Attention is All You Need"에 대해 이야기하려고 합니다.

혹시 여러분도 이 논문에 대해 궁금했던 적 있지 않으신가요?

딥러닝 모델의 복잡한 메커니즘에서 왜 '어텐션 메커니즘'이 그렇게 중요한지, 그리고 이 논문이 어떻게 인공지능 분야를 재정의했는지 지금부터 하나하나 풀어보려고 해요.

자, 그럼 함께 탐험해 볼까요? 😄

어텐션 메커니즘의 시작 ✨

"Attention is All You Need" 논문은 RNN(Recurrent Neural Network)과 LSTM(Long Short-Term Memory)의 한계를 극복하기 위해 제안되었습니다.

기존 모델들은 긴 시퀀스를 처리할 때 장기 의존성 문제를 겪었죠. 어텐션 메커니즘은 각 단어의 중요도를 스스로 계산하여 문맥을 더 정확히 파악할 수 있도록 돕습니다.

간단히 말해, 어텐션은 모델이 어디에 집중해야 하는지 알려주는 역할을 합니다. 🎯

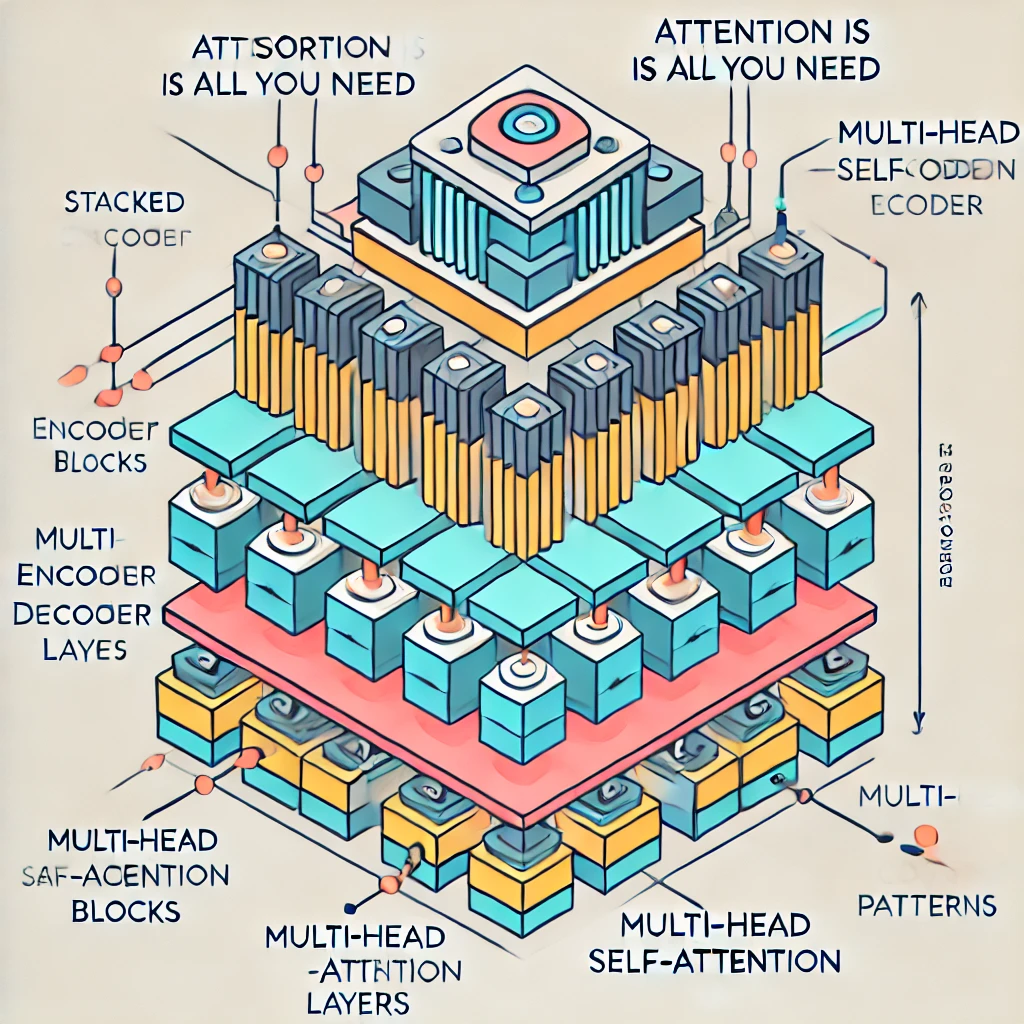

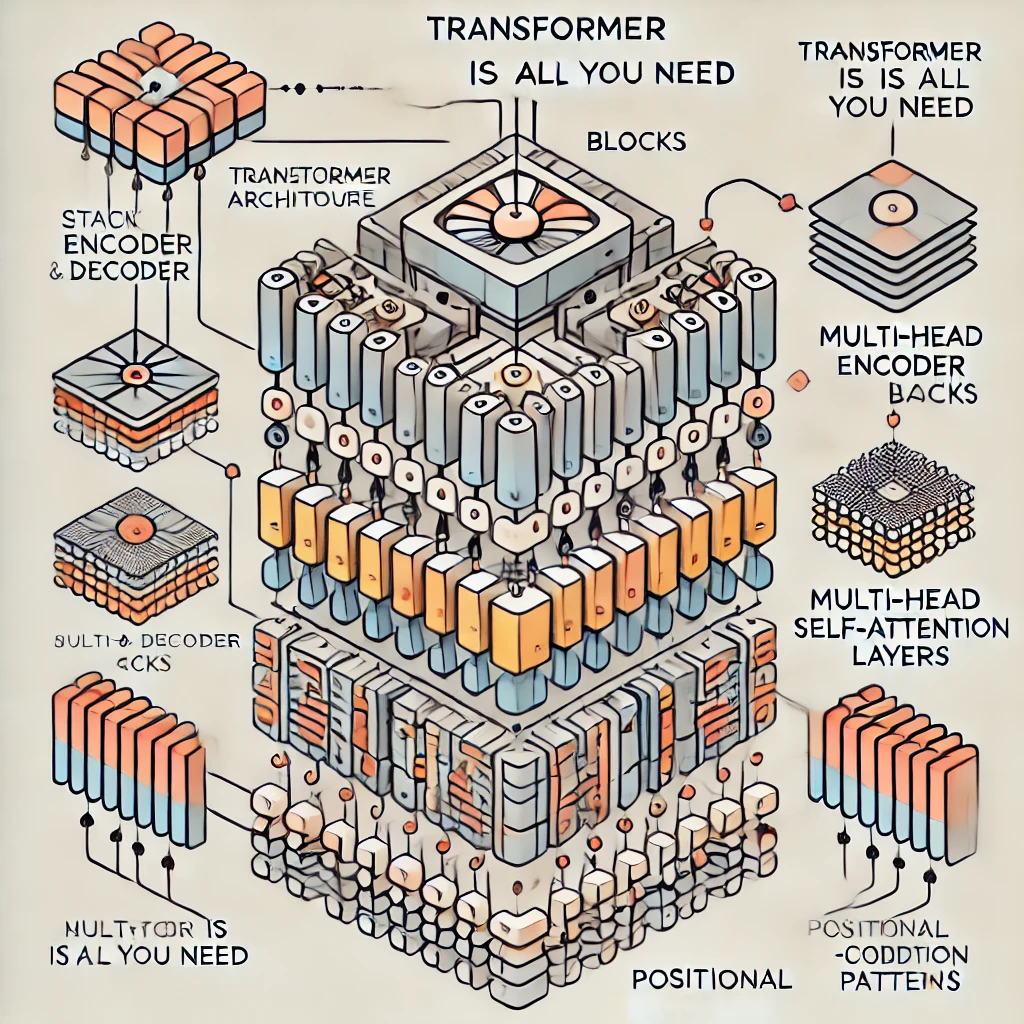

트랜스포머 아키텍처의 구조 🏗

| 구성 요소 | 설명 |

|---|---|

| 인코더 | 입력 데이터를 처리하여 의미 있는 표현을 생성합니다. |

| 디코더 | 인코더의 출력을 받아 최종 출력을 생성합니다. |

| 멀티-헤드 어텐션 | 다양한 위치에서 정보를 동시에 처리하여 모델의 이해력을 높입니다. |

어텐션 모델의 장점 💡

✅ 병렬 처리: RNN과 달리 트랜스포머는 시퀀스를 병렬로 처리할 수 있어 학습 속도가 빠릅니다.

✅ 긴 시퀀스 처리: 멀티-헤드 어텐션 덕분에 장기적인 의존성 문제 없이 긴 시퀀스를 효과적으로 다룹니다.

✅ 더 나은 성능: 자연어 처리, 기계 번역 등 다양한 작업에서 기존 모델 대비 뛰어난 성능을 보여줍니다.

트랜스포머의 영향력 🌍

트랜스포머 모델은 GPT, BERT, T5와 같은 현대 NLP 모델의 기반이 되었습니다.

자연어 처리, 음성 인식, 이미지 처리 등 다양한 분야에서 뛰어난 성능을 보이며, 특히 대규모 언어 모델 개발에 핵심적인 역할을 했습니다.

이처럼 트랜스포머의 도입은 AI 기술의 발전 속도를 획기적으로 가속화시켰습니다. 🚀

실제 적용 사례들 🚀

💡 Google 번역: 트랜스포머 기반 모델을 적용하여 번역 품질이 획기적으로 향상되었습니다.

💡 OpenAI의 GPT 시리즈: 대규모 언어 모델로서 자연스러운 대화와 텍스트 생성을 지원합니다.

💡 BERT: 문맥을 이해하는 모델로, 검색 엔진의 질의 처리 정확도를 높였습니다.

마무리 및 향후 전망 🔮

"Attention is All You Need"는 단순한 논문을 넘어 AI 연구의 새로운 패러다임을 열었습니다.

앞으로도 트랜스포머 기반 모델은 다양한 산업에서 더 혁신적인 발전을 가져올 것입니다. 🌟

자주 묻는 질문 💬

어텐션 메커니즘은 무엇인가요?

어텐션 메커니즘은 모델이 입력 시퀀스에서 중요한 부분에 집중하도록 하는 기술입니다.

트랜스포머 모델이 왜 중요한가요?

트랜스포머는 병렬 처리와 긴 시퀀스 처리 능력을 갖추어 다양한 AI 분야에서 뛰어난 성능을 보여줍니다.

트랜스포머는 어디에 사용되나요?

자연어 처리, 음성 인식, 이미지 처리, 번역 등 다양한 영역에서 사용됩니다.

트랜스포머와 GPT의 차이는 무엇인가요?

GPT는 트랜스포머의 디코더 부분만 사용하여 언어 생성에 최적화된 모델입니다.

BERT는 무엇인가요?

BERT는 트랜스포머 기반으로, 양방향 문맥 이해에 최적화된 자연어 처리 모델입니다.

트랜스포머가 앞으로 발전할 방향은?

트랜스포머는 더욱 효율적이고 경량화된 모델로 발전할 것으로 예상됩니다.

여러분, 오늘의 "Attention is All You Need"에 대한 이야기가 유익하셨나요? 😊

여러분의 생각이나 궁금한 점을 댓글로 공유해 주세요! 함께 이야기를 나누며 더 깊이 있는 내용을 탐구해 봐요.

다음에도 흥미롭고 유익한 내용으로 다시 찾아올게요. 💙

📎 관련 사이트 링크

태그: 트랜스포머, 어텐션, 딥러닝, 자연어처리, AI, GPT, BERT, 머신러닝, 논문리뷰, 딥러닝모델