그래디언트 소실 문제란? 신경망의 어려운 용어 풀이

안녕하세요 여러분! 인공지능, 딥러닝에 관심 있으신 분들이라면 한 번쯤 들어보셨을 ‘그래디언트 소실 문제’라는 용어, 어렵고 복잡하게만 느껴지셨죠?

오늘은 이 어려운 개념을 쉽고 친절하게 풀어드릴게요. 특히 신경망에 막 입문하신 분들이나, 관련 논문이나 기술서를 읽다 막히신 분들에게 큰 도움이 될 내용입니다.

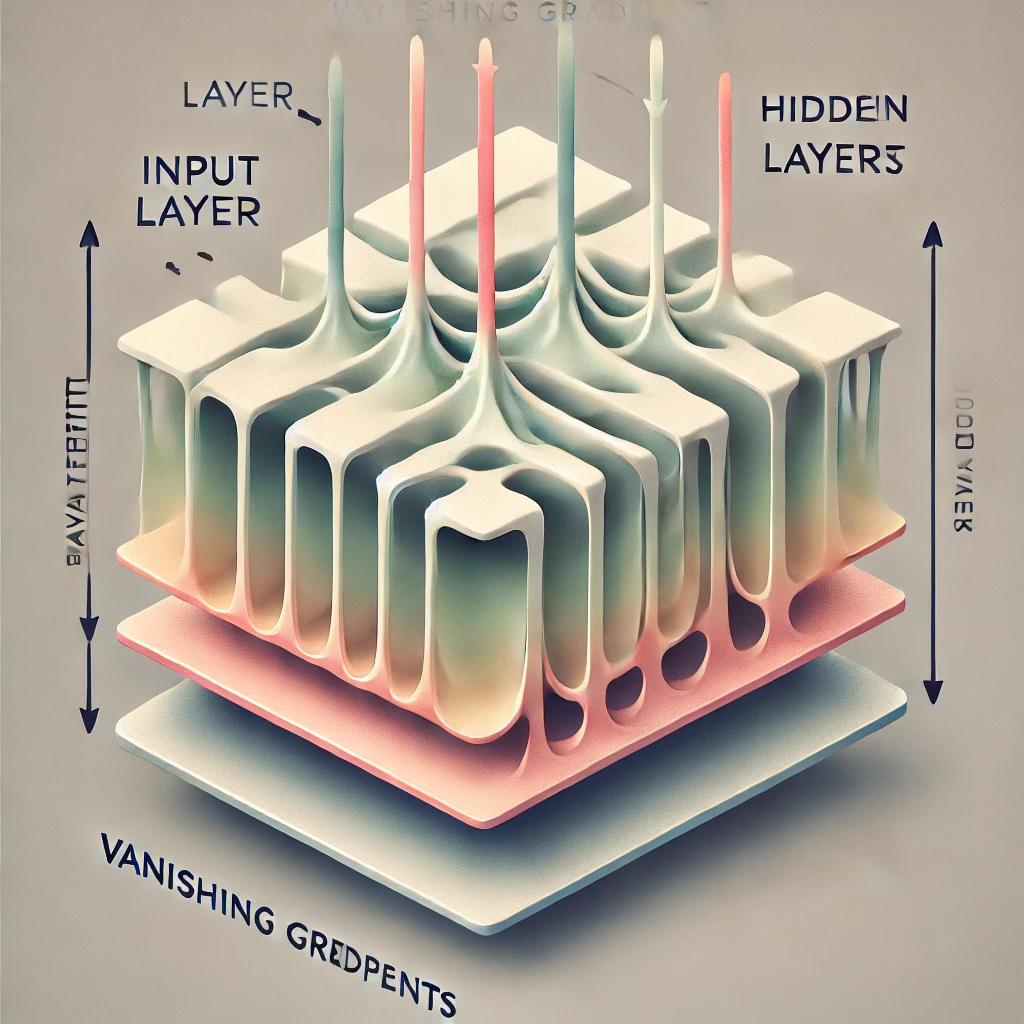

그래디언트 소실 문제란 무엇인가요?

그래디언트 소실(Vanishing Gradient)은 신경망에서 역전파(Backpropagation)를 수행할 때,

층이 깊어질수록 기울기(gradient)가 점점 작아져서 거의 0에 수렴하게 되는 현상을 말합니다.

이 문제는 가중치를 학습하기 위한 신호가 앞쪽(입력층 방향)으로 잘 전달되지 않아서

신경망이 제대로 학습되지 않는다는 큰 문제점을 가지고 있습니다.

특히 Sigmoid나 Tanh 같은 비선형 활성화 함수를 사용할 때 자주 발생하며,

딥러닝 초창기에는 이 문제 때문에 신경망 깊이를 늘리는 것이 매우 어려웠습니다.

한마디로, 앞쪽 레이어들은 제대로 업데이트되지 않고 멍하니 있는 상태가 되니,

아무리 학습해도 원하는 결과를 얻기 힘들어지는 거죠.

그래디언트 소실은 "깊은 신경망에서 학습이 멈춰버리는 현상"이라고 기억하면 이해가 쉽습니다.

발생 원인과 수학적 배경

그래디언트 소실은 주로 활성화 함수의 특성과 가중치의 초기화 방식에 의해 발생합니다.

대표적으로 Sigmoid 함수는 출력 범위가 0과 1 사이인데, 입력값이 클수록 기울기가 작아져서

역전파 시 미분 값이 매우 작아지는 문제가 있습니다.

수학적으로 보면, 역전파 과정에서는 연쇄 법칙(chain rule)을 통해 각 층의 가중치에 대해 미분이 전달됩니다. 이때 모든 층의 미분 결과를 곱하기 때문에, 만약 각 층에서의 기울기가 0.9만 되어도 100개 층을 거치면 0.9100 ≈ 0.00003 으로 거의 0에 가까운 값이 되어버립니다.

💎 핵심 포인트:

기울기의 곱셈 구조와 비선형 함수의 포화 영역이 만나면, 그래디언트가 앞쪽으로 갈수록 거의 사라지게 됩니다.

// 예: Sigmoid 함수의 미분 결과

def sigmoid_derivative(x):

return sigmoid(x) * (1 - sigmoid(x))

그래디언트 소실이 미치는 영향

그래디언트 소실은 모델의 학습 능력 자체를 심각하게 떨어뜨립니다.

특히 입력층이나 초기 은닉층에서의 가중치 업데이트가 거의 이루어지지 않아,

해당 층은 처음 상태 그대로 멈춰있는 셈이 됩니다. 결과적으로 전체 신경망이 비효율적으로 작동하게 되며,

정확도, 손실 함수 개선 모두 정체 상태에 빠지게 됩니다.

이 현상은 RNN, LSTM 같은 시계열 모델에서 더욱 두드러지며, 긴 시퀀스를 처리할수록 앞의 정보가 사라지게 되는 구조적 한계를 불러옵니다.

✅ 체크포인트 1: 모델 학습이 느리거나 아예 되지 않을 수 있음

✅ 체크포인트 2: 깊은 네트워크에서 초기층 정보가 무시됨

✅ 체크포인트 3: 시간 흐름이 긴 입력 데이터에 치명적

깊을수록 좋아 보였던 신경망 구조, 그래디언트 소실 앞에서는 오히려 약점이 됩니다.

해결 방법과 대표 기법

다행히도 그래디언트 소실 문제를 해결하기 위한 여러 가지 효율적인 기법이 제안되어 왔습니다.

대표적인 해결 방법은 다음과 같습니다.

| 기법 | 설명 |

|---|---|

| ReLU 함수 사용 | 기울기 소실을 줄이기 위한 대표적인 비선형 함수. 양수 구간에서 기울기 손실이 없음 |

| 가중치 초기화 기법 | Xavier, He 초기화로 초기 가중치 분포 조절 |

| Batch Normalization | 중간 층의 분포를 정규화하여 학습 안정화 |

| 잔차 연결(Residual Connection) | ResNet처럼 입력값을 더해주는 구조로 그래디언트 흐름을 보존 |

이외에도 LSTM, GRU 같은 RNN 구조에서는 셀 구조 자체로 그래디언트가 사라지지 않도록 설계되었으며, 이는 긴 시퀀스 데이터를 다룰 때 매우 효과적입니다.

💡 TIP: 모델 구조를 바꾸기 전, 먼저 활성화 함수와 초기화 방식을 점검해 보세요!

그래디언트 폭주와의 차이점

그래디언트 소실과 자주 함께 언급되는 또 하나의 문제는 그래디언트 폭주(Exploding Gradient)입니다.

이름은 비슷하지만, 현상은 정반대입니다. 그래디언트 폭주는 역전파 중 기울기 값이 지수적으로 커지면서 수치적으로 폭발하는 현상입니다.

| 구분 | 그래디언트 소실 | 그래디언트 폭주 |

|---|---|---|

| 문제 현상 | 기울기가 0에 수렴 | 기울기가 무한히 커짐 |

| 영향 | 학습이 멈춤 | 가중치가 NaN, 발산 |

| 대표 원인 | 활성화 함수의 포화 | 초기 가중치가 너무 큼 |

| 해결법 | ReLU, BatchNorm | Gradient Clipping |

소실과 폭주는 반대 개념이지만, 둘 다 신경망 학습을 방해한다는 점에서 매우 중요합니다.

실전에서의 대응 팁과 마무리

실전 프로젝트나 연구에서 그래디언트 소실 문제를 피하려면 몇 가지 핵심 전략을 기억해 두는 것이 좋아요.

아래 내용을 참고해서 여러분의 딥러닝 모델을 더 안정적이고 똑똑하게 설계해 보세요!

✅ 체크포인트 1: 활성화 함수는 ReLU, Leaky ReLU, GELU 등 비포화 함수 위주로 선택

✅ 체크포인트 2: He, Xavier 초기화를 통해 시작부터 튼튼하게

✅ 체크포인트 3: Batch Normalization을 적절히 섞어 사용

✅ 체크포인트 4: 필요시 Residual 구조 또는 Skip Connection 적용

💎 핵심 포인트:

깊은 모델일수록 더 정교한 설계가 필요합니다. 깊이만 쌓는다고 성능이 보장되지 않아요!

그래디언트 소실 문제는 단순한 오류가 아니라, 딥러닝 모델의 설계 철학과 학습 원리를 이해하는 핵심 키워드입니다.

오늘 내용이 여러분의 인공지능 여정에 작은 이정표가 되었길 바라요.

마무리 인삿말

여기까지 읽어주셔서 정말 감사합니다 😊

오늘은 딥러닝을 공부하면서 누구나 한 번쯤 고민하게 되는 그래디언트 소실 문제에 대해 알아봤어요.

용어는 어렵지만, 원리만 잘 이해하면 앞으로 신경망 구조를 설계할 때 훨씬 더 똑똑한 판단을 할 수 있게 될 거예요.

혹시 글을 읽다가 궁금한 점이 생기셨다면 댓글로 편하게 질문 남겨주세요!

또, 여러분만의 해결 방법이나 경험담이 있다면 함께 공유해 주시면 너무 감사하겠습니다 😊

앞으로도 딥러닝, 인공지능 용어들을 쉽게 풀어드릴 예정이니 자주 놀러와 주세요!

관련된 사이트 링크

- DeepAI - Vanishing Gradient 설명

- Analytics Vidhya - Vanishing Gradient 이해하기

- Stanford CS231n 강의자료 - Neural Network Training

- Papers with Code - Gradient Clipping 정리

태그 정리

그래디언트 소실, 딥러닝 용어, 신경망 학습, ReLU, 역전파, 활성화 함수, 딥러닝 문제 해결, 딥러닝 팁, 머신러닝, 인공지능 공부